Muy interesante

Sophos premia a Prosol como mejor MTR Services Partner of the year

Después de reunir a más de 1.200 partners en ciudades como Múnich, Milán o Manchester en anteriores paradas, el Sophos Partner Roadshow 2022 ha aterrizado en España, comenzando por Madrid, para visitar después Sevilla y Bilbao los próximos 15 y 22 de septiembre, respectivamente.

Bajo el lema “Team play at its best” y queriendo resaltar el trabajo en equipo y el éxito conjunto, Sophos celebró el jueves 9 de junio esta jornada en uno de los puntos más emblemáticos para el fútbol español.

“Mediante nuestros eventos de roadshow, hemos tenido la oportunidad de compartir con ellos nuestros principales programas de canal, servicios y las novedades de nuestras soluciones que impulsarán nuestro crecimiento para los próximos 12 meses”, comenta Jason Ellis, vicepresidente de canal de EMEA de Sophos.

Sophos Partner Roadshow 2022

Carlos Galdón, Director de Canal de Sophos Iberia ha sido el encargado de inaugurar la jornada para presentar la estrategia empresarial y el Go-To-Market de Sophos. Un canal que en Iberia alcanza a 11.000 clientes apoyados por un equipo que no deja de crecer año a año, formado por 40 profesionales técnicos y de equipos de ventas que aportar un servicio de soporte 24/7.

Además de la presentación de las últimas novedades de la compañía y su planificación estratégica amparada en su filosofía “channel first”, los asistentes han tenido la oportunidad de asistir y formar parte de sesiones técnicas y comerciales con prácticas de MSP, así como demos interactivas de hacking en vivo y de cómo funcionan las galardonadas soluciones de Sophos como XDR, ZTNA o Sophos Firewall.

Sophos reúne y premia a su ecosistema de partners en el Sophos Partner Roadshow 2022

Como cada año, la compañía ha entregado sus tradicionales Premios al Canal, en lo que reconocen el trabajo realizado por sus partners en el último año, siendo Prosol el seleccionado como MTR Services Partner of the year.

Más ventajas de Dell EMC PowerStore

Las empresas gestionan cada vez más datos en su día a día y apuestan por soluciones avanzadas que les permiten aprovecharse de todas sus ventajas.

En los últimos años el crecimiento de este tipo de soluciones ha sido exponencial. Según Markets and Markets, el mercado global de gestión de datos empresariales pasará de los 77,9 mil millones de dólares el año 2020 a los 122,9 mil millones de dólares el año 2025.

Estos datos muestran que este mercado es dinámico y que tiene mucho potencial. No obstante, para aprovechar mejor todas sus ventajas, hay que contar con almacenamiento inteligente como el que propone Dell EMC.

Dell EMC ofrece a las compañías Dell EMC PowerStore, un sistema de almacenamiento innovador que ofrece automatización y agilidad como vimos en el anterior artículo. Pero también innovaciones tecnológicas clave para ser competitivos en los próximos años.

Las ventajas que ofrece la última tecnología de Dell EMC PowerStore

Estos son los beneficios más destacados que proporciona a las empresas esta solución de almacenamiento:

1.- Tecnología de almacenamiento de próxima generación

La solución de almacenamiento incluye tecnología punta como la arquitectura NVMe de estado sólido, con mayor ancho de banda y menor latencia para satisfacer los requisitos de los SSD Flash, así como la nueva memoria de clase de almacenamiento (SCM) Intel Optane de dos puertos.

El diseño activo-activo de alta disponibilidad de PowerStore admite bloques, archivos y vVols de forma nativa en un solo sistema y ofrece una eficiencia de almacenamiento superior y constante gracias a su reducción de datos en línea y siempre activa y la deduplicación y la compresión avanzadas. También proporciona importantes beneficios de rendimiento y de aceleración de hardware con la tecnología Intel QuickAssist.

2.- Integración cloud

Las empresas pueden integrar fácilmente su infraestructura local en entornos de soluciones de nube híbrida mientras mantienen la coherencia operativa. Para los clientes de VMware y VMware Cloud on AWS ofrece una nube híbrida perfecta al extender su entorno de vSphere local a la nube de AWS y ofrecer servicios de archivos y bloques PowerStore para implementaciones de VCF.

Con la capacidad AppsON de PowerStore a través de vSphere, los usuarios pueden migrar fácilmente aplicaciones y datos entre PowerStore y AWS según los requisitos, sin requerir herramientas de administración adicionales para operaciones simples y consistentes.

3.- Escalabilidad flexible

La tecnología de crustering avanzada permite a PowerStore escalar la potencia de procesamiento del sistema hasta cuatro dispositivos y aumentar el rendimiento a medida que las necesidades de las aplicaciones crecen y evolucionan.

PowerStore puede equilibrar automáticamente el almacenamiento y las cargas de trabajo para maximizar la utilidad del sistema.

4.- Análisis predictivo y monitoreo proactivo

CloudIQ es una aplicación nativa de análisis de almacenamiento basada en la nube que incluye la solución PowerStore sin coste. Proporciona una supervisión integral del estado del sistema, el rendimiento, la capacidad, las configuraciones y las métricas de protección.

La solución combina estas métricas con el machine learning y las mediciones analíticas predictivas para mejorar la planificación de la capacidad y solucionar problemas antes de que interrumpan el negocio.

CloudIQ crea una puntuación de estado integral y proactiva para garantizar que cada dispositivo PowerStore proporciona la base óptima para ejecutar datos empresariales con la mayor disponibilidad. Una disponibilidad de seis 9: 9,99999%.

5.- Preparado para el futuro con actualizaciones en cualquier momento

Dell respalda cada sistema Dell EMC PowerStore con el programa Future-Proof que incluye una garantía de reducción de datos 4:1, así como actualizaciones en cualquier momento.

Este programa proporciona actualizaciones de datos dentro de la misma generación o próxima generación de dispositivos o escalamiento horizontal del entorno existente con un segundo sistema igual al modelo actual.

Los nodos de PowerStore se pueden reemplazar sin interrupciones mientras se conservan las unidades existentes y las rendijas de expansión, sin requerir nuevas licencias o compras adicionales.

Con PowerStore, la infraestructura se puede modernizar sin migrar la información de un dispositivo a otro, sin tiempo de inactividad y sin afectar las aplicaciones.

Prosol ofrece a las empresas Dell EMC PowerStore la tecnología punta que necesitan las empresas que quieren adelantarse al futuro.

Las ventajas de Dell EMC PowerStore

Los datos son el petróleo del siglo XXI y cada vez más empresas quieren aprovechar su potencial para obtener beneficios. Es por esto que la analítica de datos cada vez cotiza más al alza.

Según Allied Market Research, el mercado global del Big Data y la analítica de datos empresarial pasará de los 193,14 mil millones de dólares el año 2019 a los 420,98 mil millones el año 2027.

Pero, para aumentar el rendimiento de la analítica de datos y aprovechar aún más los beneficios, las empresas necesitan implementar sistemas de almacenamiento avanzados como Dell EMC PowerStore.

Dell EMC PowerStore es un sistema de almacenamiento innovador que aporta muchas ventajas a las organizaciones.

Los beneficios de Dell EMC PowerStore

Estas son algunas de las ventajas más destacadas que el nuevo sistema de almacenamiento de Dell EMC proporciona a las compañías:

1.- Arquitectura definida por software (software-defined)

El sistema está construido sobre una arquitectura de software basada en contenedores que permite la portabilidad de funciones, la estandarización y el rápido lanzamiento al mercado de nuevas capacidades y hace posible la máxima flexibilidad de implementación.

Además de los nuevos módulos desarrollados específicamente para PowerStore, las aplicaciones y características probadas de la cartera de soluciones multiplataforma de Dell EMC, que incluyen AppSync, SRM y Data Protection Suite, se pueden integrar directamente en el entorno operativo de PowerStore.

2.- Máxima agilidad con AppsON

La integración de la arquitectura definida por software de PowerStore con VMware ESXi integrado da como resultado un almacenamiento empresarial avanzado que combina los beneficios de un entorno de aplicaciones local con un entorno de administración de vSphere y los recursos del servidor.

Los beneficios de la capacidad de AppsON incluyen un nuevo nivel de agilidad para la implementación de aplicaciones, con un movimiento fluido entre los dispositivos PowerStore y los servidores VMware ESXi, así como la capacidad de reducir la pila al eliminar la huella del servidor y la red para implementaciones remotas y de borde que ahorran espacio.

3.- Menos tareas de gestión de IT

El personal IT no tendrá que dedicar esfuerzos en tareas de administración del almacenamiento, gracias a las tecnologías de Machine Learning y automatización inteligente que incorpora esta solución de Dell EMC.

4.- Automatización inteligente

La solución agiliza el desarrollo de aplicaciones y automatiza los flujos de trabajo de almacenamiento a través de la integración con un amplio ecosistema de DevOps y marcos de gestión abiertos. Admite una integración completa con la administración de VMware y sus características operativas, incluida la administración y el aprovisionamiento de almacenamiento de vSphere, VAAI, VASA y soporte nativo de vVols.

En las áreas florecientes de contenedorización y DevOps, los usuarios de PowerStore pueden aprovechar los complementos, incluidos los de CSI, Kubernetes, Ansible y vRealize Operations.

5.- Más agilidad en el desarrollo de aplicaciones

Con esta tecnología el personal IT podrá dedicarse a tareas más productivas como el desarrollo de aplicaciones. Un desarrollo que con este sistema de almacenamiento es más ágil y permite reducir los plazos de implementación de días a segundos, al ser una infraestructura programable.

6.- Operación autónoma

El nuevo sistema de almacenamiento utiliza la ubicación inteligente de datos para mejorar el uso y el rendimiento del sistema a través del aprovisionamiento equilibrado de nuevos volúmenes de almacenamiento de dispositivos, mientras que el motor de machine learning supervisa continuamente el clúster y recomienda acciones para reequilibrar los recursos del mismo, identificando y automatizando los cambios necesarios para mantener un nivel de eficiencia óptimo.

Prosol proporciona a las organizaciones la mejor solución de almacenamiento para que estas puedan beneficiarse de todo el potencial de la transformación digital.

Dell EMC PowerStore, el nuevo sistema de almacenamiento avanzado

Las empresas demandan cada vez más la analítica de datos. Esta funcionalidad les aporta muchas ventajas, pero para obtener el máximo rendimiento de ella, necesitan un buen sistema de almacenamiento.

Para responder a los retos de la transformación digital y al intensivo uso de datos, las organizaciones necesitan hacerse con soluciones de almacenamiento avanzadas.

En este entorno, las compañías apuestan con más frecuencia por Dell EMC PowerStore, un nuevo sistema de almacenamiento.

¿Qué es Dell EMC PowerStore?

Dell puso en el mercado en mayo de 2020 Dell EMC PowerStore para mejorar la simplicidad y la agilidad operativa del almacenamiento a través de una arquitectura con contenedores, tecnologías de almacenamiento avanzadas y automatización inteligente.

Se trata de un sistema de almacenamiento que está basado en una arquitectura que se caracteriza por lo siguiente:

- Escalamiento horizontal

- Reducción avanzada de datos acelerada por hardware

¿Para qué se utiliza Dell EMC PowerStore?

La solución de almacenamiento aprovecha mejor los recursos y mejora el desempeño para poderse adaptar al crecimiento de aplicaciones y sistemas.

Ofrece muchos beneficios con tecnología avanzada.

La tecnología de Dell EMC PowerStore

El nuevo sistema de almacenamiento avanzado de Dell utiliza la tecnología VMware ESXi, procesadores escalables Intel Xeon y tecnologías punta de almacenamiento como NVMe Flash y SSD Intel Optane de dos puertos y reducción de datos en línea siempre activa.

1.- VMware ESXi

Es un hipervisor bare metal avanzado que ofrece la posibilidad de acceder directamente a los recursos subyacentes y controlarlos.

Cuenta con capacidades específicas para realizar particiones de hardware de manera eficaz con el objetivo de consolidar las aplicaciones y reducir los costes.

Es un referente en el sector por su arquitectura eficiente y por ser fiable, altamente rendible y por su soporte.

2.- Procesadores Intel Xeon

Utiliza procesadores escalables como Intel Xeon Platinum, preparado para cargas de trabajo exigentes en datos, análisis en tiempo real e Inteligencia Artificial (IA) que ofrece fiabilidad y una durabilidad elevada.

3.- NVMe Flash

Es un nuevo protocolo de transporte y almacenamiento para unidades Flash y de estado sólido (SSD) que ofrece un rendimiento alto y tiempos de respuesta muy cortos para toda clase de cargas de trabajo empresariales.

El funcionamiento del protocolo consiste en el acceso al almacenamiento flash a través del bus PCI Express (PCIe) que admite miles de colas de comando paralelas para adquirir una velocidad mayor que la de los discos duros y las arquitecturas all-flash tradicionales limitadas a una única cola de comandos.

4.- SSD Intel Optane

Se trata de una tecnología que se basa en tecnología 3D Xpoint que puede llegar a alcanzar una velocidad hasta mil veces más rápida que la memoria SSD convencional.

Esta memoria es tan potente que no solo se puede utilizar para almacenar datos, sino también como memoria RAM extendida.

Una memoria que ofrece una inteligencia avanzada que permite localizar siempre los datos a los que se accede con más frecuencia para acceder más rápido a los mismos.

Toda esta tecnología funciona en una arquitectura preparada para las necesidades de las empresas de hoy.

La arquitectura de la nueva solución de almacenamiento de Dell EMC

El sistema se basa en una plataforma versátil de almacenamiento de escalamiento horizontal y vertical que, además de ofrecer un potente procesamiento de datos con el procesador Intel Xeon y tecnologías de almacenamiento avanzadas, utiliza análisis, automatización y equilibrio activo de recursos.

En este sistema los dispositivos utilizan dos nodos de almacenamiento activo-activo y una arquitectura de software basada en contenedores para ofrecer la máxima adaptabilidad.

Además, las empresas que demanden más almacenamiento, pueden ampliarlo con tres ranuras de expansión.

La solución se encarga de optimizar el rendimiento y de suprimir los gastos generales de gestión

Prosol ofrece a las empresas Dell EMC PowerStore para que estas puedan aprovecharse de las ventajas de la transformación digital con un almacenamiento capaz de responder a las necesidades actuales.

¿Está tu empresa preparada para la vuelta a la oficina?

La pandemia del Covid ha planteado un reto a las empresas a la hora de primero, mandar a sus trabajadores a casa, y segundo planificar (O al menos intentarlo) como sería la vuelta de dichos trabajadores a las oficinas. Esto plantea retos desde el punto de vista espacial (No podremos estar tan juntos como estábamos antes), pero aún más retos desde el punto de vista del acceso a las aplicaciones a través de las redes de Campus porque toca redimensionar nuestras redes Wifi (o las tradicionales basadas en cables); y al mismo tiempo que reforzamos la seguridad porque el perímetro de la empresa sigue aumentando, y por tanto la superficie de ataque es todavía más grande.

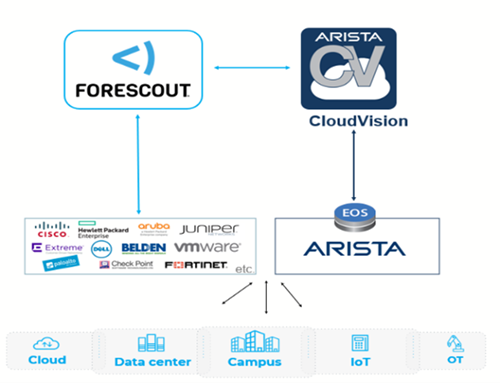

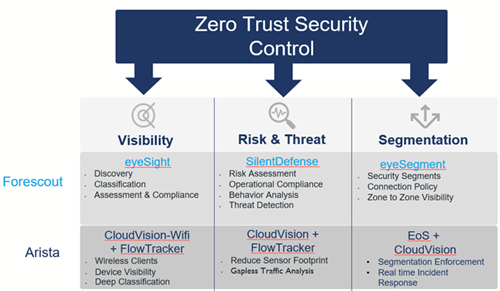

Este nuevo reto se debe traducir en soluciones que hagan la gestión de la seguridad y de la red más sencilla, lo que siempre ha implicado integraciones de diferentes tecnologías con funcionalidades avanzadas que tienen que trabajar de forma coordinada. Entendiendo por integración no solo un despliegue correcto de la solución, sino una automatización de su funcionamiento para asegurar que solucionará evolucionará con las necesidades que surjan una vez se haya desplegado. Aquí es donde un uso amplio de APIs que simplifican la integración de los componentes de una solución es obligatorio. En este entorno de trabajo, tengo que destacar la propuesta de Arista a través de CloudVision, que permite integrarse con Forescout para dotar de conectividad segura a organizaciones de todo tipo y tamaño, como muestra la imagen

Permitiendo esta integración aprovechar las funcionalidades avanzadas de cada tecnología. Arista ofrece conectividad a lo largo de toda la organización con herramientas avanzadas de monitorización, gestión y troubleshooting; mientras que Forescout permite asegurar dichas redes de comunicaciones dentro del perímetros de la organización. Todos lo tenemos claro, los potenciales “atacantes” cruzarán el perímetro antes o después, y tenemos que asegurar que la red no permite movimientos laterales al mismo tiempo que nuestros usuarios no se ven penalizados en su actividad diaria por las medidas de seguridad.

El alineamiento de las dos tecnologías es total, y como hemos dicho la integración permite no solo dotarse de las funcionalidades de las dos tecnologías, sino que evita caer en el “vendor lockin” de otros fabricantes que solo trabajan con ellos mismos.

Prosol, como socio de negocio de ambas empresas, está preparado para ayudarte a afrontar el reto de la vuelta a la oficina.

Certificado Commvault CASP

Este año 2020 continuamos siendo la primera compañía en España con el certificado Commvault Autorized Support Partner (CASP).

Gestionar el ‘vendor lockin’ en entornos de multicloud híbridos

Desde Prosol insistimos en utilizar tecnologías con capacidad para ser usadas en diferentes entornos tanto on premise como en las nubes públicas. Tecnologías que permiten cumplir con la flexibilidad, la escalabilidad, la mutabilidad y la portabilidad requeridas, y evitan en la medida de lo posible el vendor lockin

Las principales razones para implementar Data Domain

Cuando hablamos de protección de la información, Data Domain es una solución más que interesante debida a su gran ventaja competitiva en relación al rendimiento de la herramienta y la sencilla escalabilidad que proporciona.

Data Domain es una solución de almacenamiento con protección de datos, basada en tecnología Intel Xeon que tiene como objetivo mantener la información de la organización protegida en todo momento.

Ahora mismo, la pregunta que debes estarte formulando es: ¿Hay miles de soluciones de este tipo, por qué Data Domain debería ser mi elección? Vamos a detallar algunos puntos:

Rapidez en la ejecución de operaciones

La tecnología única de Dell Technologies con Data Domain Stream-Informed Segment Layout (SISL) y Data Domain Boost es capaz de operar a tasas que pocos pueden igualar, llegando hasta 68 TB por hora. Tal cifra para una tasa de velocidad de respaldo es asombrosa.

Arquitectura propia de Dell Technologies: “Invulnerabilidad del dato”

El término “Invulnerabilidad del datos” ha sido acuñado como una forma de diseñar los appliances y se ha convertido, de hecho, en una arquitectura única de Dell. Los procesos de respaldo y archivo son el almacenamiento de último recurso y Data Domain proporciona tecnología y herramientas adecuadas para asegurar la integridad de los datos de las unidades mediante verificaciones en tiempo real, además de herramientas complementarias de protección, como detección continua de errores y autorreparación en caso de error.

Deduplicación única en el sector

La segmentación de longitud variable de Data Domain proporciona tasas de deduplicación que deriva en un menor almacenamiento y un ahorro en el consumo de espacio del appliance. Además, esto supone otros beneficios más indirectos como una mejor escalabilidad, menor infraestructura que administrar al necesitar menos dispositivos y minimizar el coste de adquisición de infraestructura.

La nube en la palma de la mano

El Cloud Computing es indispensable para las empresas de hoy en día, tanto por seguridad, eficiencia en sus operaciones como para los trabajadores que se encuentran en movilidad. Data Domain integra de forma nativa diferentes conectores a los principales proveedores cloud de nube pública. Los beneficios en este punto se traducen en una retención de datos a largo plazo mucho más eficiente, reduciendo drásticamente el TCO al trasladar al proveedor ese coste, y gracias a la deduplicación de datos también en el almacenamiento en la nube, el tráfico de la red es menor y no es necesario en la mayoría de casos adquirir infraestructura adicional para soportar el movimiento de datos a la nube.

Escalabilidad sencilla y con cero complicaciones

La escalabilidad es esencial para cualquier negocio que crece y necesita que su infraestructura lo acompañe y no sea un impedimento. Es por ello que en la protección de datos, la escalabilidad debe ser un punto esencial en la elección de proveedor. Con Data Domain, la escalabilidad es vertical y es posible administrar hasta varios PB en un solo sistema.

Flexibilidad y protección de la inversión = ROI asegurado en poco tiempo

La flexibilidad de Data Domain es única y está pensada de forma concienzuda para integrarse sin complicaciones en los sistemas de la organización. Es por ello que la solución se adapta con las herramientas existentes de respaldo, de Big Data o en el almacenamiento primario. Además, a nivel físico, Data Domain tiene múltiples formas de conectividad, tanto por fibra como red, por lo que es posible escoger qué tipología es la más adecuada en cada situación.

Data Domain está diseñado desde cero para ser un sistema de almacenamiento de último recurso. Por ello, es necesario una fiabilidad y rendimiento excepcional admitiendo todo tipo de integraciones y despliegues. De hecho, Dell Technologies es un vendor a tener en cuenta en cualquier proyecto de almacenamiento o protección de datos gracias a una tecnología única que lo diferencia de la competencia.

¿Cómo almacenas la información? ¿Almacenas en la nube, en un entorno híbrido? Quizás quieras conocer Unity, la solución de almacenamiento unificado de Dell Technologies. ¿Hablamos?

Somos una empresa especializada en la modernización de las infraestructuras IT, adaptándolas a los requerimientos de las aplicaciones que sostienen los procesos de negocio, optimizando su coste total de propiedad y aprovechando los datos que estas generan para convertirlas en información, y mejorar la toma de decisiones de negocio.

Para ello colaboramos con proveedores tecnológicos plenamente establecidos en el mercado español y desarrollamos alianzas con nuevos fabricantes que ofrecen tecnologías innovadoras.

Nuestro elemento diferencial es contar con un equipo de profesionales multidisciplinar y con una clara orientación de servicio a nuestros clientes.

Prosol es tu socio tecnológico ideal para la optimización de las infraestructuras de Tecnologías de Información tradicionales y para abordar la Transformación Digital de tu negocio. ¿Te ayudamos?

Qué debes saber si quieres implementar Dell EMC Unity

Cuando hablamos de almacenamiento, Dell Technologies es uno de los referentes a tener en cuenta como vendor destacado en el sector. Y es que la línea Dell EMC Unity está diseñada para el rendimiento, optimizada para la eficiencia y creada para la nube híbrida, además de proporcionar lo último en simplicidad.

Además, gracias a la flexibilidad en las opciones de implementación, tanto all-in-flash como híbrida, proporciona una cobertura para la mayoría de casos de uso posibles.

A la hora de desarrollar un proyecto de almacenamiento, los clientes finales suelen optar por implementar un array híbrido como almacenamiento. Desde Prosol, veamos 5 razones de peso para desplegar la infraestructura con Dell EMC Unity.

Eficiencia de la tecnología híbrida

Los clústers de Unity híbridos combinan la potencia y el rendimiento del flash con la rentabilidad que ofrece el espacio en disco. Estos sistemas de almacenamiento híbridos aprovechan la tecnología de Dell EMC para pools virtuales (FAST VPTM) para la organización en niveles y el software de caché para SSD, Fast Cache para optimizar el rendimiento y el uso del almacenamiento flash.

Pensado en la simplicidad

Unity representa el máximo exponente en simplicidad. Los sistemas están pensados para ser implementados y sencillos de configurar. De hecho, lo es tanto que la instalación de un rack y su colocación se realiza en unos pocos minutos y su configuración entre 15 y 25 minutos. Todo ello gracias a paneles HTML5 diseñados específicamente para este propósito y con tecnología VMware y Microsoft que proporcionan las integraciones necesarias para poder funcionar cuanto antes y con la mayor sencillez posible.

Un stack con todo incluido

Todas las configuraciones de Unity con Flash incorporan el software necesario para almacenar, gestionar y proteger la información gracias al panel de control desarrollado específicamente para Unity:

- Múltiples protocolos unificados.

- Snaphots simplificados y unificados.

- Fast Cache para optimización de la tecnología Flash.

- Integración con AppSync.

- Cifrado de datos en reposo.

- QoS, multi-tenant, retención de ficheros, RecoverPoint para MVs…

Unity es un paquete completo, con todo lo necesario para empezar. La tecnología y el software han sido desarrollados a medida para poder cubrir la mayoría de casos de uso de la industria.

Listo para la nube

Cada unidad Dell EMC Unity viene con el derecho de usar conectores para la nube para el almacenamiento en niveles de archivos y el archivado de instantáneas en bloque en las nubes de Microsoft, Amazon, IBM, Virtustream y ECS con capacidades completas de migración de repositorio en la nube. Los clientes pueden liberar almacenamiento inactivo ahorrando en CAPEX Y OPEX mientras reducen simultáneamente sus ventanas de respaldo.

Sistema de ficheros totalmente escalable

Los appliances Dell EMC Unity All-Flash son ideales como NAS para empresas o como dispositivos transaccionales. El sistema de archivos de Unity, UFS64, incluye hasta 256 clones VMDK independientes e instantáneas que ahorran espacio y generan un bajo impacto de E / S, obteniendo el beneficio de una reducción del sistema de archivos.

Gracias a un sistema de ficheros más eficiente se simplifican las cuotas para usuarios, árboles y grupos y los failovers se realizan mucho más rápido y sin interrupciones.

Es importante destacar que cada array proporciona replicación de archivos sincrónica y asincrónica, con soporte para Metrosync Manger para monitorear ambos lados de la replicación, detectar interrupciones y ejecutar un failover del NAS sincronizado y replicar de origen a destino.

Es evidente que no solo porque es un appliance llave-en-mano y que su configuración y puesta en marcha es sencilla, sino que la escalabilidad y automatización una vez el dispositivo se encuentra en producción, hacen de Unity una solución única para asegurar la información de la organización y poder dormir cada noche sin tener que preocuparse de si los datos a la mañana siguiente seguirán ahí, donde deberían estar.

¿Cómo almacenas la información? ¿Almacenas en la nube, en un entorno híbrido? Quizás quieras conocer Unity, la solución de almacenamiento unificado de Dell Technologies. ¿Hablamos?

¡GANA TIEMPO! ¡El fin del soporte de Windows Server 2008 y Windows Server 2008 R2 ya está aquí!

El 14 de enero de 2020 finalizará el soporte de Windows Server 2008 y 2008 R2. Esto significa que ya no habrá actualizaciones de seguridad periódicas. No dejes tu infraestructura y tus aplicaciones desprotegidas. Estamos aquí para ayudarte a ganar tiempo contra las vulnerabilidades y las brechas de seguridad.

Prosol te aporta una solución con la tecnología de Virtual Patching de Trend Micro con la que puedes tener una seguridad completa para entornos físicos, virtuales, híbridos y en la nube aunque estos estén basados en tecnologías sin soporte.

¡Consigue tu Consultoría GRATUITA con PROSOL!

El proceso es muy sencillo, solo tienes que decirnos en qué estás interesado y te llegará un informe sobre la tecnología o la solución seleccionada:

- ¿Te interesa saber más sobre alguna tecnología?

- ¿Te interesa saber más sobre alguna solución?

CONSIGUE TU INFORME PINCHANDO AQUÍ

Y tranquil@… No habrá ninguna acción promocional a posteriori a no ser que se solicite expresamente.

Si por el contrario, desea que le llamemos para ampliar información indíquenoslo enviando un correo a info@prosol.com

MongoDB: Copia de seguridad

Estamos ya incorporando de forma masiva las tecnologías de No-SQL en nuestras aplicaciones y servicios TI. Una de las que me encuentro más frecuentemente es la de la base de datos documental MongoDB, y me gustaría compartir mi preocupación por la escasa atención que se presta a las operaciones de copia de seguridad de este tipo de entornos. Entiendo que se produzca cuando libros como “Mastering MongoDB 3.X” de Alex Giamas (2017), que he utilizado para tratar de conocer con cierto detalle el funcionamiento de la plataforma, plantea una base de datos que permite a los desarrolladores su total independencia de un DBA tradicional (El mensaje de la base de datos autónoma de Oracle da continuidad a esta idea). La parte de Ops en el concepto de DevOps se nos cae. Partiendo de esta idea, el autor vuelve a la realidad cuando describe las diferentes operativas para optimizar los entornos y sacar partido de la plataforma, y detalla cómo hacer frente a la operativa diaria básica que requiere toda base de datos y que habitualmente hace un DBA (Optimización de queries, análisis de rendimiento, balanceos, índices, etc.).

Uno de los puntos que más me llamó la atención es la parte dedicada a las copias de seguridad, a la que dedica más tiempo del habitual en este tipo de libros. Plantea varios escenarios de trabajo: réplicas, replicas en la nube en un servicio de MongoDB-as-a-Service, réplicas con retardo en un nodo, snapshots, copia de un nodo desconectado & copia de los logs, dumps del sistema, copias del file system sobre el que se apoya la base de datos (A lo bruto), etc. Vamos que alternativas no faltan, y mejor utilizar la consola que te ofrece la versión de pago para hacer estas cosas.

Las limitaciones vienen cuando uno pone las funcionalidades de replicación (Réplica Sets) y particionado (Sharding) en funcionamiento, que habitualmente se hace para hacer frente a volúmenes grandes de datos y necesidades de rendimiento. En ese momento, el autor prefiere quitarse de en medio y recomendar hacer uso de una aplicación específica de backup porque todos los planteamientos anteriores empiezan a ser un engorro más que una ayuda. Esto me lleva a insistir en una tecnología de copias de seguridad para este tipo de bases de datos (También para la base de datos columnar Cassandra) que compró Rubrik hace meses ya, y que ha incorporado a su plataforma. Tiene una integración con MongoDB que permite hacer copias programadas en caliente, copias consistentes a nivel base de datos, copias completas e incrementales, etc.; pero lo más destacable es que permite hacer recuperaciones PIT (Point in Time) y en clústeres de igual o distinta tipología de la que hicimos backup (Lo más habitual que me he encontrado es un clúster de tres nodos en producción, y una configuración “single-node” en preproducción, aunque no es lo recomendado por el autor del libro), que es justo la operativa que el autor del libro indica como necesaria para poder hacer frente a los riesgos más habituales en este y cualquier sistema TI.

Me alegra comprobar que el backup no es un pensamiento secundario en el planteamiento del libro, me alegrará más cuando vea sus recomendaciones en práctica.

En cualquier caso, el libro ofrece una visión completa de la plataforma, y es de lectura recomendada para los que nos queremos saber un poco más de este tipo de herramientas.

¿Quién dijo que la nube era barata?

En vacaciones tenemos tiempo para lecturas más o menos espesas, espero esta sea de las menos espesas.

En mi caso, ya no estoy de vacaciones, y me ha llamado la atención este artículo al respecto de empresas que parecen ir a la contra del mercado: Se “bajan” cosas de la nube (IaaS) a su propia infraestructura dedicada. Son ejemplos de empresas que descubren que la nube lleva a unos gastos operativos de difícil control, y en ciertos casos muy elevados cuando las cargas que tenemos desplegados en la nube son estables (O al menos buena parte de las mismas lo son), o muy ligadas a otros entornos. Estas mismas empresas afrontan la dificultad de estimar los costes reales de cuánto costaría desplegar estas mismas cargas en una infraestructura dedicada (Hay una comparativa de costes de almacenamiento, que no me termino de creer porque la media no es el único factor que distorsiona los costes de un sistema de almacenamiento), pero que aun así deciden saltar de la nube a la tierra.

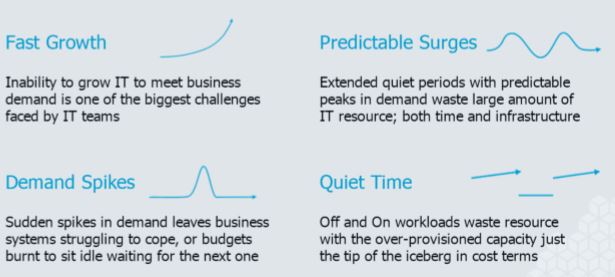

No hemos terminado de subir, cuando ya nos empiezan a hablar de bajar. Veo en este artículo una confirmación de que muchas veces olvidamos la condición necesaria para que la nube (IaaS) sea barata, y es que la baratura se da cuando lo que necesitas es flexibilidad. Cuando no la necesitas, puede que tenga sentido la aproximación “híbrida”. Por híbrido no hablo de aplicaciones que desbordan a la nube en caso de necesidad (Algo de lo que todo el mundo habla, pero que con las aplicaciones tradicionales veo complicado o casi imposible), sino de servicios IT desplegados “abajo” y servicios IT desplegados “arriba”, con una cierta integración.

Podéis leer el artículo aquí:

https://www.theregister.co.uk/2019/08/09/repatriation_cloud_data/

Si quieres saber cómo podemos ayudarte a tener éxito en los entornos nube y en los terrenales, puedes ver cómo en www.prosol.com

Certificado HCI VMware

Queremos compartir con vosotros la competencia HCI que hemos obtenido para dar a nuestros clientes la mejor solución adaptada a cada necesidad de negocio. Ayudamos a reducir el coste total de propiedad del almacenamiento, automatizar la gestión del mismo y gestionar su rendimiento.

Prosol es una empresa especializada en la modernización de las infraestructuras IT, adaptándolas a los requerimientos de las aplicaciones que sostienen los procesos de negocio, optimizando su coste total de propiedad y aprovechando los datos que estas generan para convertirlas en información, y mejorar la toma de decisiones de negocio.

Para ello colaboramos con proveedores tecnológicos plenamente establecidos en el mercado español y desarrollamos alianzas con fabricantes como NetApp que ofrecen tecnologías avanzadas como es Storage GRID. Un referente en el mercado de sistemas de almacenamiento basados en arquitecturas de crecimiento horizontal, dentro del área de los repositorios de objetos.

Cuando hablamos de almacenamiento de datos masivos, tenemos que pensar en el rendimiento, pero fundamentalmente tenemos que considerar la escalabilidad del sistema como factor fundamental. La escalabilidad tenemos que contemplarla desde diferentes vectores:

- ¿Con qué efectividad gestiona los datos a medida que el número de objetos en el almacenamiento pasa de millones a miles de millones?

- ¿Cómo se comporta el sistema cuando alcanza los Petabytes de capacidad gestionada?

- ¿Cómo gestiona los diferentes nodos que compone la plataforma de forma que se asegura de que los datos se encuentran en las ubicaciones correctas a la vez que garantiza una tolerancia a fallos completa?

- ¿Cómo se asegura de que los datos que almacena siguen siendo legibles durante años si no se accede apenas o nunca a ellos?

- ¿Cómo se asegura de que cumple tanto los requisitos de gobierno corporativos como los normativos?

- ¿Cómo retiene datos durante períodos que pueden equivaler a varias generaciones de hardware de almacenamiento?

- ¿Cómo se asegura de que los datos se almacenan en los soportes más económicos a lo largo de todo su ciclo de vida?

El hecho es que ya son muchas las organizaciones que disponen de un elevado volumen de datos, que habitualmente son datos no estructurados. Archivos, logs, backups, imágenes, vídeos, etc. La manera más eficiente de poder sacarles partido pasa por ser capaz de almacenarlos en un sistema que responda a todas las preguntas anteriormente planteadas. Hasta ahora ha sido complicado disponer de una solución efectiva para responder a estos retos, por lo que debía solucionarlos usted mismo. Sin embargo, esto es exactamente lo que ha logrado NetApp con StorageGRID. Con esta tecnología las organizaciones de todo tipo disponen de una plataforma para gestionar volúmenes de datos masivos de forma eficiente, garantizando su durabilidad y acceso a lo largo de muchos años gracias al uso de protocolos estándares de acceso al sistema como S3 o RestFul, tecnologías compatibles con las existentes en la nube.

Me gustaría destacar la capacidad de integración de StorageGRID con el resto de las tecnologías de NetApp, en particular con su tecnología de servicio de ficheros desplegada en sistemas de almacenamiento basadas en el sistema operativo OnTap. Esta integración permite descargar los sistemas productivos de máximo rendimiento de los datos de menor acceso, emplazándolos en StorageGRID de forma completamente transparente a los usuarios de la información. Esta funcionalidad permite mantener la metadata de la información archivada, moviendo exclusivamente los bloques de información “fríos” al sistema de almacenamiento secundario de forma que optimizamos el coste de almacenar los datos.

Dada la increíble capacidad de crecimiento del sistema, ésta es solo una de las muchas maneras en las que puede sacar partido al mismo. El retorno de su inversión será mayor cuantos más tipos de datos emplace en este dispositivo, dado que la gestión de cientos o miles de TB puede realizarla un número mínimo de personas gracias a las herramientas avanzadas de gestión y monitorización de las que dispone la plataforma.

En Prosol contamos con más de 25 profesionales cualificados y certificados para encontrar e implantar la mejor solución, integrándola en el entorno del cliente limitando riesgos y asegurando el éxito en la gestión de datos masivos, lo que habitualmente representa un para muchos. StorageGRID de NetApp es el almacenamiento de objetos definido por software y de escalado masivo que se ha diseñado específicamente para grandes archivos, repositorios de medios, almacenes de datos web y como repositorio de datos de aplicaciones de última generación, basados en micro-servicios desarrallados en entornos DevOpp.

En Prosol, llevamos más de 20 años ayudando a las empresas a beneficiarse de las nuevas tecnologías, mejorando sus servicios TI existentes y optimizando el coste de sus infraestructuras.

No dude en contactar con nosotros para que podamos ayudarle a tener la mejor infraestructura adaptada a sus necesidades.

Contacta con nosotros en info@prosol.com

Simplifique la movilidad de su empresa y de verdadera libertad a los trabajadores

Con DellEMC y Awingu, cree un espacio de trabajo en línea, seguro, accesible, para cualquier navegador y dispositivo.

Gran parte de las medianas y grandes empresas han tenido históricamente infraestructuras muy costosas para dotar a sus empleados de un acceso a las aplicaciones corporativas. Esto ha ido cambiando dado que en muchas ocasiones la infraestructura no es rentable para estas empresas.

La infraestructura de Dell EMC es ideal para organizaciones que buscan un entorno de hiperconvergencia y Awingu es la combinación ideal para reducir costes de infraestructura y de mantenimiento para un entorno de workspace.

Proporcione acceso remoto a cualquier empleado de la compañía, sin importar el dispositivo y el usuario. Solo necesitará un navegador HTML5.

¿Quiere saber porque la mayoría de las empresas se están cambiando a la hiperconvergencia de DELL y escogen Awingu para dar libertad a su fuerza de trabajo?

- ¿Qué es Awingu?

- Las principales ventajas de un Workspace ideal para Pymes con Awingu

- Awingu en Gartner

- Workspaces con VxRail, la hiperconvergencia de Dell EMC

- Casos de Éxito

Prosol participa en la jornada "Migrar a la nube de forma correcta"

El encargado de abrir el debate fue Rafael Arroyo de Prosol quien en su opinión, “seguimos aprendiendo y viendo para qué quieren la nube las empresas. Creo que va a haber un dinamismo cada vez mayo y un incremento en volumen de ventas. Además, pienso que vamos claramente hacia la nube híbrida porque el consumo de recursos IT va a ir creciendo”. Para Antonio Pizarro de OVH, la clave del mercado cloud en el miedo de las empresas a adoptar las diferentes fórmulas de nube: “Nuestra base de clientes siempre han sido nativos digitales pero los clientes onpremise no han dado el paso por el miedo al cambio. Este miedo, sin embargo, ya se ha perdido porque todas las empresas ya tienen algo en cloud y por eso todos los proyectos en cloud se han acelerado. Ahora, lo que intentan solucionar es cómo se gestiona la cloud híbrida porque la parte que siguen teniendo en onpremise no se puede eliminar así como así”. Para Damien Peteau, “son varios los factores que explican el impulso de la adopción del cloud en las empresas, pero podemos destacar la agilidad que proporcionan las aplicaciones en la nube, la reducción del time to market, la facilidad de poder crecer rápidamente (horizontalmente o verticalmente) y la posibilidad de desarrollar pruebas de concepto (PoC)”.

Por su parte, Miguel Ángel Martos de Symantec afirmó que “migrar a la nube es una realidad aunque no todas las empresas hacen esta migración de la misma forma. Ahora mismo casi todos los procesos que se implementan en las empresas se incorporan a la nube. La nube representa una mejora en la productividad y por ello la adopción de cloud no es algo de lo que las empresas puedan permitirse prescindir de ello”. Para Marc Granados de Econocloud, “hace 10 años era una odisea vender cualquier cosa en cloud. Ahora es algo a lo que todo el mundo está yendo y va a seguir creciendo. La cuestión que hay que hacerse es, ¿y luego qué? Mi opinión es que para migrar a la nube van a surgir nuevas necesidades, por ejemplo todo lo relacionado con el edge computing”. Por su parte, José Juan Díaz de Barracuda cree que “la flexibilidad que otorga cloud ha permitido que todas las empresas decidan dar el salto a la nube. Esto ha permitido que las empresas confíen porque es más seguro que hace unos años. Cloud ha venido para quedarse y se va a convertir en uno de los componentes imprescindibles en los flujos de trabajo de una empresa”. Por su parte Txema Táboas, de Semantic Systems cree que “se está acelerando el crecimiento de soluciones o servicios en cloud, aunque es verdad que depende del sector del que se hable. En mi opinión, en los próximos años, va a haber un equilibrio entre los diferentes tipos de nube según las necesidades de la empresa”.

Cloud híbrida

Uno de los apartados a los que más tiempo se dedicó fue el de la cloud híbrida dado que parece que es el modelo que actualmente está triunfando entre las empresas. En opinión del portavoz de Barracuda, “la ventaja de la nube híbrida es que permite decidir dónde van a escoger sus soluciones. La cloud híbrida es lo más implantado y dado que las medidas de seguridad se han incrementado vamos a ver que cada vez se van a incorporar más flujos de trabajo a la nube”. Para Marc Granados, a la hora de analizar los modelos en nube, “se puede dividir en dos, los tipos de cliente. Por un lado, existen clientes, que son empresas ya consolidadas y que apuestan infraestructura híbrida y luego están las startups que directamente ya han empezado en la nube pero que cuando se asienten, irá yendo a la híbrida”. El portavoz de Wolters Kluwer afirmó que “teóricamente, cloud híbrido, debería ofrecer más seguridad y permitir más posibilidades de tuning, pero también se pierde flexibilidad y oportunidades de reducir costes por tener una infraestructura dedicada a sí mismo”.

El portavoz de Symantec consideró que “hay funciones que serán escalables al cloud y otras que lo serán menos. El movimiento al cloud no es más que una transformación en la forma de gestionar TI. Cada vez vemos más compañías que son directamente cloud first. Así que cada empresa decidirá ir a una nube o a otra según sus necesidades”. El representante de OVH señaló que desde su compañía “no creeemmos en un modelo único de cloud. Creemos que de lo que se trata es de pensar en cuál es la necesidad que tiene el cliente. No es lo mismo una startup que una empresa grande, por eso hay que poner el foco en el tipo de negocio de una forma clara”.

Finalmente Rafael Arroyo afirmó que la adopción de un determinado tipo de nube, “ya no es un tema tecnológico. En muchas ocasiones depende de la organización de la empresa y cómo ve IT. Hay empresas que toman decisiones por las sensaciones que tiene el equipo de gerencia, que por ejemplo prefiere comprar una licencia que estar pagando todos los meses por esa licencia. Hoy predomina el híbrido, pero a medio o largo plazo no lo sabemos”.

Multicloud

La apuesta por nubes de diferentes proveedores es una de las grandes tendencias de estos momentos por parte de las empresas. ¿Es una apuesta correcta? Para el portavoz de Prosol, “depende de los beneficios que ofrezca a las empresas. El multicloud requiere de ser capaz de gestionarlo y eso hay que ver si a una empresa le compensa frente a ir a un monocloud. Multicloud no es algo a lo que haya que ir obligatoriamente. Creo que sí se va a imponer como tendencia, pero hay que hacerlo poco a poco”. Por su parte Antonio Pizarro de OVH cree que “las empresas ya trabajan con aplicaciones que en si mismas ya son un multicloud. El multicloud tiene que ser operable y la tendencia es la de buscar proveedores que ofrezcan estándares abiertos y que sean reversibles”. Por su parte, el portavoz de Symantec afirmó que “cuando hablamos con los clientes, no hablamos de ir a la nube, sino de ir a las nubes. Desde la ciberseguridad, se está viendo que se están produciendo cambios salvo dos cosas: el dato y el usuario que accede al dato. En torno a eso se monta la estrategia de operar la ciberseguridad en la nube”. Para Marc Granados, “la clave está en la interoperabilidad entre los diferentes servicios que tenemos en las nubes. Es decir la posibilidad de mover de AWS a Google, por ejemplo… Esto es algo que le interesa a las grandes empresas que tienen muchas máquinas, pero no lo veo útil para las pymes”.

El miedo a migrar a la nube ya se ha perdido porque todas las empresas ya tienen algo en cloud y por eso todos los proyectos en cloud se han acelerado.

El portavoz de Barracuda consideró que “una apuesta multicloud es aprovecharse de las ventajas de cada una de las plataformas. Aquí el canal tiene mucho que decir para orientar al cliente. Además, hay que tratar de mantener un estándar entre todas estas plataformas, incluida la parte que está en local”.

Estrategia

Uno de los problemas con los entornos cloud es que las empresas tienen claro que quieren apostar por la nube pero, desde luego, no tienen clara la estrategia que tienen que seguir, lo que provoca, por ejemplo, un incremento de los costes o no sacar el partido necesario a un determinado tipo de solución o servicio. En este sentido, el portavoz de Semantic Systems cree que “las empresas no tienen clara la estrategia de migración a la nube y lo hacen por que por ejemplo lo hace su competidor, pero no sabe para qué le vale. Hay otros que no quieren hablar de ello aun cuando hay cosas que si pueden subir a la nube”. En la misma línea se posicionó el portavoz de Barracuda ya que en su opinión “hay muchos flujos de trabajo que no tiene sentido llevar a la nube. Es algo que las empresas deberían saber”.

Marc Granados de Econocloud opinó que “es lícito que una empresa no quiera ir a la nube pero se me hace difícil pensar que a medio plazo sea sostenible. Todas las empresas lo van a acabar haciendo tarde o temprano”. Para Miguel Ángel Martos “uno de los problemas es que muchas empresas no saben que ya tienen servicios en el cloud. La agilidad es uno de los factores esenciales para ir hacia la nube. Cada empresa tiene sus motivos para no ir, pero si el motivo es el de la seguridad, no hay que tener esa prevención porque se hace con garantías”. Por su parte, desde Wolters Kluwer se afirma que “las empresas deberían adaptar sus aplicaciones y gestión de datos para que puedan ejecutarse en un entorno cloud. Un primer paso es IaaS, pero PaaS es lo que realmente nos proporciona los mayores beneficios (costes, HA, DR, crecimiento). El cambio de mentalidad de toda la empresa es imprescindible para entender y aceptar los nuevos conceptos (especialmente pago por uso) e integrarlos en los planes de producto (performance improvement, re-architeture, etc.)”.

Por su parte, desde OVH se afirmó que “habría que preguntar a las empresas qué tipo de proyectos quieren llevar a la nube. Toda la parte relacionada con la transformación digital es saber que es algo que tiene que ser flexible, con un presupuesto que no es cerrado y que tiene que ir a un proyecto a 5 años, por ejemplo”. Finalmentel Rafael Arroyo de Prosol cree que el error está en considerar a cloud como algo estratégico, “cuando no lo es. Cloud no es más que un servicio o herramienta más. Se trata de ver qué estrategia como empresa quiero, sin importar la nube o no. Una vez que hagas el análisis de estrategia de empresa hay que traducirlo en estrategia IT y decidir si se va a la nube o no”.

Coste

Uno de los argumentos de venta más recurrentes es el ahorro de costes que produce la nube. Sin embargo, esto no es del todo cierto si no se produce un correcto análisis de lo que se pretende conseguir con la migración a la nube. Para el portavoz de Prosol, “la nube es barata si lo que quieres es agilidad y rapidez. Hay casos en los que a lo mejor solo necesitas un housing y ya está. Si no necesitas ni agilidad ni rapidez, lo mismo no necesitas nada de cloud”. Para Antonio Pizarro, “Cloud en un principio sonaba más fácil, pero ahora es muy difícil es hacer una predicción real de los costes en cloud. Hay poca claridad por parte de muchos proveedores. Además la impredecibilidad hace imposible saber cuál va a ser el coste real”. Por su parte el portavoz de Symantec afirmó que “la ciberseguridad es un factor importante en los servicios cloud. En este mundo hemos pasado de ofrecer tecnologías de seguridad a servicios de ciberseguridad. Esto ocurre porque los clientes ven que esto ofrece una confianza que no daba hace unos años”. Desde Econocloud, Marc Granados considera que “hay empresas que emplean la nube desde hace años. Por ejemplo, las agencias de viajes son las primeras que vieron que cloud les resultaba más económico y podía atender picos de demanda y lo podían hacer con seguridad. A día de hoy, el coste del cloud depende de lo que quieras hacer. Si hablamos de si es más económoco, la respuesta es un no. Por concepto, es más caro pero si el uso es temporal, necesita recursos de picos estacionales y entonces sí sale a cuenta”. Desde Barracuda se afirma que “el ahorro de costes sólo se produce si utilizamos todos los recursos del cloud. En los ROIs nunca se habla de temas como electricidad o problemas derivados de un ciberataque. Al final hay que comparar el nivel de servicio que tenemos en local con lo que tenemos en la nube”. Finalmente el portavoz de Semantic Systems cree que el coste sale más barato dependiendo de los que se contrate: “Por ejemplo, en soluciones de Oracle o de Telefónica va a salir más barato que un licenciamiento. Por ejemplo, en servicios gestionados sale más barato que tenerlo en casa. Si buscas un determinado servicio, también sale más barato”.

Seguridad

Finalmente se habló del hándicap de la seguridad, aunque éste, cada vez es menor ya que las empresas se han dado cuenta de que la nube es cada vez más segura. Para el portavoz de Symantec, “la seguridad tiene que ser el habilitador de cloud porque si no es segura, el cliente no va a apostar por ella. El proveedor se responsabiliza de determinados datos, pero el último responsable es el propio dueño del dato y esto lo tienen que saber las empresas. Hay que incorporar mecanismos del control del dato y control del usuario y esto permitirá migrar al cloud de forma segura. Una realidad es que hemos pasado de una etapa en el que la seguridad se consultaba una vez que se migraba al cloud. Ahora es al revés, se consulta la estrategia de seguridad y luego se migra”. Finalmente, José Juan Díaz de Barracuda cree que “todo depende de si la nube está bien o mal configurada. Hay que buscar soluciones que nos permitan estandarizar la seguridad esté donde esté nuestro dato. Cloud nos ha permitido tener una visión mucho más clara de dónde está nuestro dato. El hecho de externalizar los datos nos ha permitido ver dónde están, aplicar plantillas de cumplimiento y por tanto la seguridad se ha convertido en un catalizador de la nube. Además ha permitido que la seguridad tenga un valor para el cliente que antes no se tenía”.

Revista Byte IT

Las Cintas siguen dando guerra

La cinta está muerta. Todo será nube, primero con discos y después discos de estado sólido hasta para almacenaje de datos fríos o muy fríos. Lo único que no sabemos es cuándo, y mucho menos ahora que los nuevos formatos multimedia plantean almacenamientos todavía más masivos (¿Quién dijo Peta cuando puedes tener Exa?).

Para complicar todavía más el futuro, encontré el otro día un artículo que destacaba porque hablaba de esta tecnología, la cinta y sus drives, olvidada por muchos, pero muy presente para otros. Las cintas desembocaron casi completamente en un formato único y estándar para todo el mercado, el LTO, salvo para los incombustibles IBM y Oracle en el mundo mainframe. En la nueva generación de drives (Y ya vamos por la octava) quedan vivos varios fabricantes de drives, pero solo dos fabricantes de cintas y ambos están peleados por temas de patentes (Es muy complicado alcanzar la densidad de datos prometida), lo cual parece que ha producido un desabastecimiento de cintas a nivel global con pocos visos de resolverse en un corto plazo. Tenéis el artículo en:

¿Compraste un LTO8? Parece que tendrás que seguir con cintas de la generación 7, y esperar a que el problema se resuelva. Eso sí, la cinta a pesar de los pesares parece estar viva todavía.

El diablo está en los detalles … de la nube

Todas las tecnologías disponibles en el mercado tienen sus pros y sus contras. Resulta complicado en muchas ocasiones identificar cuáles son las mejores áreas de aplicación de cada una de ellas, bien porque nuestras necesidades son cambiantes o bien porque el fabricante de turno plantea su tecnología como la más apta para todo tipo de entornos y festividades.

La nube no es una excepción, y cada vez más hay comparadores de las diferentes alternativas que ofrecen los proveedores de nube pública como los que estuve revisando en estos enlaces:

Recursos IaaS de cómputo

Recursos de almacenamiento:

https://www.parkmycloud.com/cloud-pricing-comparison/

Es una comparativa parcial. No están todos los que son, y olvida que hay proveedores de servicio locales. Lo que está claro es que se ha industrializado una oferta, que tiene unas especificaciones fijas, pero no identifica la mucha letra pequeña que acompaña a este tipo de planteamientos: Costará entender la factura y el esquema de descuentos, habrá limitaciones en otras áreas igualmente importantes (redes, seguridad, anchos de banda, IO, número de operaciones), la responsabilidad será compartida (Todo aquello más allá del IaaS es cosa del usuario), el impacto de no disponer de un entorno dedicado es siempre desconocido, la incompatibilidad total o parcial con otras propuestas de nube, etc., etc.

Todo esto lleva a que el alineamiento de las infraestructuras con las aplicaciones y servicios a los que dan servicio sea un elemento crítico en toda organización que se apoye en la tecnología para tener éxito (¿Hay alguna que no lo haga?), y da igual si es en su CPD o en la nube. Toca entrar en el detalle, toca analizar y planificar y ser muy puntilloso si no se quiere morir de éxito, siendo muy flexible en la contratación de nuevos recursos pero insostenible económicamente porque la factura se dispara hasta el infinito y más allá al no contratar lo estrictamente necesario.

Contacta con nosotros para que podamos ayudarte a encontrar la mejor solución adaptada a tus necesidades de negocio.

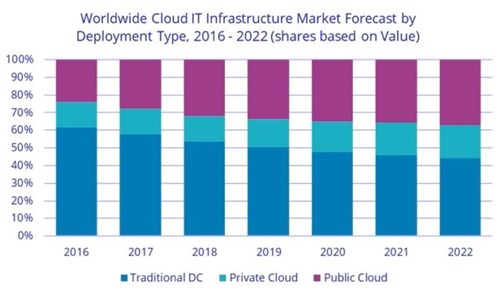

IDC opina que la apuesta por el Cloud sigue creciendo

IDC opina que la apuesta por el Cloud sigue creciendo, pero crece más la apuesta por el Cloud Privado externalizado en proveedores de CPD

Una vez más, IDC ha arrojado agua fría sobre la noción de que las empresas buscan cerrar sus centros de datos, y en lugar de eso, buscan crecer.

El último estudio de mercado mundial realizado por International Data Corporation (IDC) encontró que los ingresos por ventas de equipos de infraestructura de TI aumentaron un 48,4 % año tras año en el segundo trimestre de 2018 a $ 15,4 mil millones.

El gasto en la nube privada alcanzó los $ 4.6 mil millones, un aumento del 28,2 % año tras año. Esto es un aumento significativo, pero no tan grande como el aumento en el gasto en infraestructura de TI en la nube pública, que fue de $ 10.9 mil millones, un crecimiento interanual del 58,9 por ciento.

Para finales de año, IDC proyecta que el gasto en la nube pública representará el 68.2 por ciento del gasto total en equipos de TI, creciendo a una tasa anual del 36.9 por ciento. Sin embargo, esto no es sorprendente, ya que Amazon, Microsoft, Google, etc., compran servidores en decenas de miles de unidades.

IDC elevó su pronóstico para el gasto total en infraestructura de TI en la nube en 2018 a $ 62,2 mil millones con un crecimiento anual de 31.1%, y eso es más de tres modelos diferentes de implementación de computación en la nube: nube pública, nube privada local y nube privada en centros de proceso de datos externos. Desafortunadamente, IDC no desglosó las ventas locales y externas, pero es claramente un mercado en crecimiento.

Externalizar la Nube Privada

Lo nuevo y en crecimiento es la nube privada fuera de las instalaciones de una empresa. Aquí es donde una empresa compra y es propietaria del equipo, pero el equipo está alojado en las instalaciones de un proveedor externo como Telefónica o público como Equinix. Esto permite a las empresas expandir la capacidad de su centro de datos sin tener que hacer una inversión de capital o despojarse del dolor de cabeza de ejecutar una instalación y su administración posterior, que es más difícil y más costosa que las propias infraestructuras.

Y se nota en una desaceleración en las ventas fuera de la nube. Si bien el mercado creció 21.1 % año tras año, IDC espera que la infraestructura de TI tradicional no en la nube para el año crezca solo en un 10.3 % y comience a disminuir en 2019. Para 2022, el gasto en TI no en la nube representará solo el 44 % de gasto total en infraestructura de TI en todo el mundo, frente al 51.5 % en 2018.

"A medida que la participación de los entornos de la nube en el gasto general en infraestructura de TI sigue aumentando y se acerca al 50 %, es evidente que la nube es ahora la norma. Una de las tareas para las empresas ahora es no solo decidir qué recursos de la nube usar, pero en realidad, cómo administrar múltiples recursos en la nube ", dijo Natalya Yezhkova, directora de investigación para infraestructura y plataformas de TI en IDC, en un comunicado.

Si después de leer este artículo necesitas que te ayudemos a gestionar tus datos contacta con nosotros. Te ayudaremos a encontrar una solución adaptada a tus necesidades,

MICROSOFT WINDOWS VIRTUAL DESKTOP (WVD): Escritorios en la nube y casos de uso

Microsoft anunció la versión beta pública de su escritorio virtual, construido en Azure, con integración con O365. Esto es algo importante para Microsoft, y quizás una pequeña revolución para todos.

Los más viejos del lugar recordarán lo que la revolución del PC supuso. Antes de eso, terminales tontos sobre sistemas compartidos, dependientes de un cómputo centralizado, esclavos de un sitio y por tanto de un horario y acceso limitados.

Después del PC y más tarde con la llegada de Internet, el usuario tuvo la posibilidad de trabajar de forma independiente primero desde un escritorio, después desde su casa y hoy en día desde cualquier sitio con entornos basados en Awingu.

La era “post-PC”, de la que se viene hablando desde hace unos años, para Microsoft pasa por WVD como evolución directa del clásico PC hacia entornos basados en la Nube.

Las alternativas existentes actualmente al desktop de Windows cásico de Microsoft, como podría ser MacOS o Linux, llevan tiempo orientados o bien a perfiles técnicos específicos siendo la tendencia general de estas compañías (p.e Ipad PRO) una evolución hacia entornos de trabajos orientados a la nube, siempre conectados y sin estar anclados a un hardware determinado. Google Chormebook con ChromeOS es un claro ejemplo de hacia dónde vamos y cuál es la visión para los próximos años, sistemas “siempre conectados” donde los usuarios puedan editar un documento o acceder a información sin depender del dónde ni del cuándo.

Desde el presente artículo, me gustaría ofrecer una idea de lo que es WVD como la visión de MS sobre el escritorio del futuro, y analizar dónde y cómo pueden ayudarnos las soluciones de espacio de trabajo de Prosol allí donde un escritorio virtual no es la mejor alternativa (ni la más barata).

Comenzando por el principio. ¿Qué es WVD?

Desde 2017, Microsoft ha estado trabajando en RDMI (literalmente “Infraestructura moderna de escritorio remoto”). Inicialmente, esto se suponía que era la evolución de RDS para escritorios locales y de Azure, donde la parte de Azure se convertiría en una plataforma RDS PaaS.

Este proyecto en la parte de Azure ha ido evolucionando hacia lo que ahora conocemos como WVD, que ofrece Windows 10 VDI multisesión en Azure, donde los componentes RDP de la infraestructura se ejecutan como servicio PaaS y son administrados por Microsoft.

Según Microsoft, el Windows para Desktop tal y como lo conocemos actualmente será un producto de nicho. Este cambio se basa en la nueva característica multisesión de Windows 10 y es interesante porque puede ayudar en la reducción de infraestructura y en coste de licenciamiento para VDI, pero de momento sólo estará disponible en Azure, no siendo posible usarlo como un W10 multi sesión sin la capa de WVD.

Por ello, en resumen, la idea de Microsoft es evitar que pueda ser usado por otras nubes públicas o privadas, obligando en esos casos (AWS, Citrix) a usar la ya conocida licencia de usuario único basada en VDI tradicional si se quiere utilizar un escritorio completo de W10.

La propuesta de Prosol como alternativa o complemento a WVD

Desde hace ya un par de años, en Prosol apostamos por esta evolución del puesto de trabajo, el cambio de paradigma en la forma de trabajar y comunicarse dentro de la empresa lleva un tiempo evolucionando, pero no siempre tener un escritorio completo al que acceder desde un terminal es la mejor alternativa ni la más segura.

Una de las preguntas frecuentes a las que nos enfrentamos por parte de nuestros clientes durante el último año es cómo podemos dar a los usuarios un escritorio accesible desde cualquier parte que sea seguro. Para ello desde Prosol ofrecemos soluciones VDI y también Awingu, donde vemos una combinación de ambas tecnologías al ser soluciones diferentes y complementarias.

Sobre WVD y Awingu, a un alto nivel podemos estimar las siguientes características individuales:

- Windows Virtual Desktop:

- Solo para Azure.

- Centrado en una propuesta VDI como multi sesión de Windows 10.

- Requiere licenciamiento de Windows 10 (sobre distintos formatos).

- Sin multi-tenant completo.

- Sólo entornos completos de Microsoft. (típicamente parte de entornos de acuerdos Enterprise).

- Espacios de trabajo basados en Awingu:

- Para cualquier nube, pública o privada.

- Basado en agregación de aplicaciones y ficheros.

- También accesible como VDI, Windows o Linux.

- No requiere licencia de Windows 10 (por ejemplo, los usuarios pueden usar un equipo con Chrome OS y conectar a una sesión o aplicación RDS).

- Multi-tenant, incluyendo escenarios multi dominio.

- Cualquier tipo de fabricante.

¿Elijo entonces Awingu o WVD?

No es necesariamente una cuestión de elección, Awingu puede integrar WVD agregando la multi sesión de los escritorios Windows 10 y también las aplicaciones que corren detrás. Así, el usuario final puede tener un panel único de gestión con aplicaciones, acceso seguro a ficheros (NAS) y escritorios corriendo independientemente de su ubicación, dispositivo, nube…

Con Awingu corriendo en el top de una solución basada en WVD, se puede conectar directamente con los escritorios en Azure de multi sesión Windows 10 añadiendo a las ventajas de esta solución los siguientes elementos:

- Autentificación multi-factor (autentificación de dos pasos), que está integrada de forma nativa.

- Grabación de sesión de usuario integrada.

- Auditoria completa de uso.

- Único punto de acceso donde la administración de red es gestionada por el cliente y dispone de la posibilidad de añadir elementos de seguridad propios ( vs. Un bróker compartido de WVD).

- Agregación de distintos tipos de usuario: Este punto es quizá de los mas importantes, dado que no todos los usuarios requieren de un desktop completo en Azure. Parte de los usuarios simplemente necesiten conectar a determinadas aplicaciones, algunas de ellas aun sin subir a la nube (por ejemplo acceso a un NAS corporativo), otros no requieran una experiencia completa de Windows (por ejemplo usuarios de Chromebooks)… Hay muchos tipos y Awingu permite definir distintos perfiles de uso.

- Simplicidad en la gestión de usuario: Actualmente WVD requiere del uso de scripting en PowerShell, lo que obliga a tener perfiles de administradores determinados. Awingu permite la gestión de estos usuarios de forma gráfica y sencilla.

En resumen

Como venimos indicando a lo largo del tiempo en Prosol, la revolución del puesto de trabajo se está produciendo y se hace visible cada día que pasa más.

Combinando la visión de Microsoft sobre escritorios virtuales mediante WVD con un workspace HTML5 como es Awingu podemos disponer de lo mejor de los dos mundos y avanzar en un puesto de trabajo accesible desde cualquier parte, cualquier dispositivo de forma segura y auditada.

Rafael Arroyo: Director General Adjunto de Prosol. “LA NUBE NO ES UNA ALTERNATIVA SINO UNA OBLIGACIÓN PARA LAS ORGANIZACIONES”

“Desde Prosol tenemos claro que la nube no es una alternativa, sino una obligación para todas las organizaciones de este país. Da igual el tamaño o el sector, es algo que han de afrontar. Y en nuestro caso, lo que tenemos claro es que la nube va a ser siempre híbrida. Por eso, la propuesta de Prosol pasa por intentar aunar ambos mundos y sacar el máximo partido del potencial de cada uno de ellos. A ese hermanamiento llegamos dotando de

herramientas, procesos y puentes a las compañías para que puedan transitar de un modelo a otro. Ese puente es ayudar desde un punto de vista global a las organizaciones para poder adoptar esta tecnología y sacar el máximo partido. Planteamos utilizar nubes ya sean hiperescalables o de proveedores de servicio locales y utilizar nuestra experiencia en el mundo on premise para generar esa hibridación alcanzando el máximo partido”.

Lee la noticia completa pinchando aquí

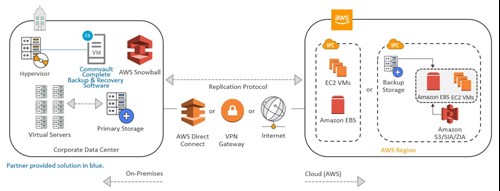

El éxito de la transformación digital con Commvault y la nube pública

El éxito de la transformación digital depende de la pericia de los departamentos TI a la hora de implementar nuevos modelos y arquitecturas digitales que hagan a la empresa mucho más flexible y competitiva para la era de los datos. Para ello, una estrategia de nube efectiva es posiblemente de las más relevantes.

Independientemente de que el enfoque tomado sea con la nube o totalmente en ella, hay que disponer de una infraestructura adyacente al almacenamiento y al proceso en la nube que facilite mover, administrar y usar los datos de forma que el negocio se vea beneficiado en el cambio de una plataforma tradicional.

Una estrategia de cloud computing bien implementada, como la que ofrecemos en Prosol, incluye la optimización de la gestión de datos e infraestructura y la optimiza de modo que sea:

- Resiliente a cambios drásticos en picos de proceso, extendiendo las cargas de trabajo a un entorno cloud.

- Recuperación frente a desastres en cuestión de horas al migrar las cargas de trabajo al entorno cloud escogido de terceros.

- Respaldo de datos a un proveedor cloud de terceros.

Al trasladar cargas de trabajo a la nube, podemos desplegar infraestructura y servicios de manera más rápida, escalar a medida que crece el negocio y reducir costes gracias a un modelo de pago por uso.

Por esta razón, cada vez más organizaciones hacen uso de la nube en busca de mejoras en escalabilidad, agilidad y rentabilidad de sus actividades TI: MVs, bases de datos o datos.

En el segmento de proveedores de nube pública, uno de los proveedores cloud más utilizados por su amplia compatibilidad con la mayoría de aplicaciones y servicios (incluidos los de Commvault) es Amazon Web Services, o AWS por sus correspondientes siglas.

Las soluciones de AWS, orquestadas por la infraestructura y software de Commvault, ofrecen la promesa de simplificar el salto a la nube y proporcionar entornos de backup mediante Internet o físico, Disaster Recovery en la nube en un modelo de DRaaS y migrar las cargas de trabajo a la nube de forma fácil y eficiente.

Migrar cargas de trabajo locales a la nube con Commvault y la infraestructura de AWS con la ayuda de Prosol

Las herramientas de Commvault y la infraestructura de AWS permiten trasladar aplicaciones, bases de datos y otros procesos para obtener un salto cualitativo en flexibilidad del centro de datos, ganar en control de la infraestructura al no depender del HW y disponer de analíticas en tiempo real. Todo desde una misma consola y orquestado mediante la suite de Commvault y la arquitectura diseñada para integrarse con AWS.

Acelerar la llegada a la nube con Commvault

Los líderes de TI que buscan flexibilidad y ahorro de costes pueden sorprenderse al saber que la protección de datos suele ser un impulsor de las migraciones a la nube como en los esfuerzos de modernización de TI.

Gracias a la suite de Commvault, puede combinar los objetivos de su migración de datos en la nube, la iniciativa de modernización de TI y los planes de protección de datos para que pueda mover más datos y ejecutar más aplicaciones en la nube.

Los CIOs, como impulsores activos de la transformación digital, pueden crear un plan de migración a la nube integral que incluya la automatización y la orquestación de aplicaciones, bases de datos, máquinas virtuales y demás elementos que consideren oportuno a la nube de AWS. Todo en una arquitectura desarrollada por los dos proveedores líderes en sus respectivos ámbitos.

La consolidación de múltiples productos de protección de datos puede significar una reducción del riesgo en el tiempo de inactividad, pérdida de datos, velocidad de recuperación y cumplimiento regulatorio, como de SLA.

El software de Commvault puede ayudar a mover sus cargas de trabajo a través de plataformas con solo unos pocos clics, acelerando su tiempo de valoración al migrar a AWS.

Commvault y AWS son el puente que une la infraestructura tradicional y un modelo cloud híbrido que optimiza la explotación de la nube pública. Al aprovechar las copias de respaldo se reduce el riesgo y se ven simplificados los movimientos nativos hacia y desde la nube para migrar por completo las cargas de trabajo críticas a la nube, incluyendo el cumplimiento, el gobierno de los datos y la copia de seguridad. Con este paso, garantizamos la seguridad de los datos desde y hacia la nube gracias a múltiples protocolos de autenticación y encriptación de datos, tanto en el lugar como en movimiento.

En Prosol asesoramos a nuestros clientes para que gracias a las herramientas de Commvault, puedan mover más datos y ejecutar más aplicaciones en la nube pública y migrar a AWS.

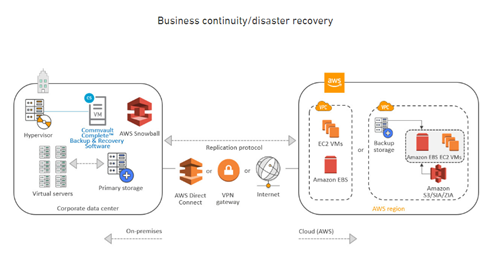

La recuperación de desastres en la nube nube con AWS y Commvault

Por qué proporcionar una recuperación operacional de las aplicaciones de un sitio primario a un sitio secundario mediante un proveedor cloud de terceros

La batalla para mejorar la continuidad de negocio de las organizaciones se juega indudablemente en la nube mediante un modelo híbrido. El cloud computing y el almacenamiento en la nube permiten a las organizaciones poner en funcionamiento verdaderos procesos de disaster recovery para asegurar la continuidad de negocio para cargas de trabajo con menos recursos y menos complejidad.

Dicho esto, queda ver qué modalidades de nube pueden ser las más interesantes según el tipo de disaster recovery que requiera nuestro negocio. ¿Qué me interesa más, una nube privada o pública?

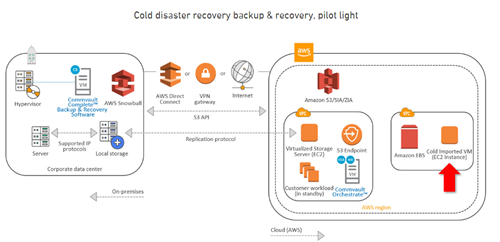

Tipologías de recuperación de desastres con Commvault y AWS

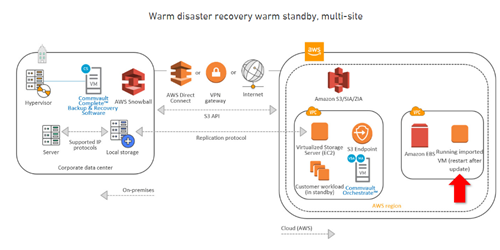

Amazon Web Services y Commvault han desarrollado una arquitectura con múltiples casos de uso que habilitan a empresas de cualquier tamaño, con o sin delegaciones que puedan disponer de un entorno en la nube que asegure la continuidad de negocio, mediante un modelo de recuperación de desastres frío o templado.

¿Frío, templado o caliente?: Clasificación de DR

Cuando hablamos de recuperación de desastres, debemos tener el foco puesto en la ubicación desde la cual puede ser ejecutada. La ubicación o sitio de respaldo será el centro neurálgico donde se recreará el centro de datos para no detener la productividad.

Según el DR (Disaster recovery, de sus siglas en inglés) requerido, hay diferentes sitios de respaldo: fríos, templados o calientes. No, no hacen referencia a términos relacionados con la temperatura, sino en la adecuación o el esfuerzo requerido para comenzar las operaciones en el sitio de respaldo durante un incidente.

Un sitio de respaldo frío es un espacio habilitado en un edificio configurado apropiadamente. Todo lo que se necesite para restaurar el servicio a los usuarios se debe conseguir y entregar a este sitio antes de comenzar el proceso de recuperación. Este es el modelo menos costoso.

Seguimos avanzando en complejidad y esfuerzo y pasamos a un DR templado. En este caso el sitio de respaldo está equipado con el hardware aproximando una representación fiel de lo encontrado en el centro de datos. Para restaurar el servicio, se debe realizar un proceso de recuperación de MVs y otros elementos críticos para mantener la continuidad de todo el ecosistema de servicios y aplicaciones disponibles antes del desastre.

Finalmente, pasamos por un DR caliente, la opción más completa de todas, donde hay una representación equivalente al centro de datos en el que se produce un incidente y solo es necesario replicar las cargas de trabajo en este segundo entorno para recuperar la normalidad. Este escenario es para los SLA más exigentes y permite poner en marcha el servicio en unas pocas horas.

Estos dos últimos modelos de DR pueden ofrecerse como un modelo DRaaS, mediante un proveedor cloud de terceros, como AWS y orquestar todo este proceso en conjunto con Commvault Complete.

DRaaS con Commvault y AWS

Con Commvault y AWS puede optimizar la recuperación de desastres en la nube al implementar una solución de extremo a extremo con los flujos de trabajo preconstruidos, y con procesos simplificados como el aprovisionamiento y la creación de imágenes.

El objetivo es convertir una nube pública o híbrida en una extensión natural del centro de datos, con el mismo nivel de seguridad, control y gestión de acceso como el mismo hardware on-premise de las instalaciones, pero con la velocidad, flexibilidad y ahorro de costes de la nube.

El DR cubre muchos casos de uso, donde algunos donde Commvault y AWS son especialmente eficientes:

- Almacenamiento fuera de las instalaciones y DR en la nube: Solo utilizar la infraestructura cuando se produce un evento DR, ahorrando tiempo y dinero (modelo IaaS y DRaaS).

- Migración de MVs a la nube: Convertir MVs VMware e Hyper-V en instancias AWS bajo demanda.

- Base de datos y archivos: Restaurar datos y DB fuera del lugar, ya sea bajo petición o como tarea programada para mantener actualizados los recursos para DR.

- Orquestación de un evento DR: Desarrollar un flujo de trabajo para facilitar la automatización y simplificar la complejidad de un evento de DR, ya sea para escenarios de prueba o DR reales.

En Prosol, facilitamos a nuestros clientes la optimización de la recuperación de desastres en la nube al ayudarles implementar soluciones de Commvault y AWS.

Cómo Commvault almacena y realiza backup en Amazon Web Services

Commvault tiene el objetivo de proteger los datos en la ubicación principal en un proveedor de terceros en la nube pública, o conservando una copia local y replicando los datos de copia de seguridad / archivo (ya sea en su totalidad, o solo porciones selectivas de esa información) en un proveedor de nube externo. El servicio de almacenamiento es adecuado tanto para configuraciones de retención a corto como a largo plazo.

El almacenamiento en la nube es uno de los factores principales para asegurar la continuidad de las empresas. El crecimiento del volumen de datos obliga a las organizaciones a desarrollar nuevas estrategias que aprovechen la agilidad y el modelo de pago por uso de la infraestructura cloud para conseguir una TI mejor y más eficiente. Commvault aborda la escalabilidad en la arquitectura de cloud computing mediante bloques de construcción de deduplicación y deduplicación de lado del cliente.

El uso de herramientas de proveedores nativos en la nube, así como la creación de una instantánea de una instancia basada en la nube, puede ser fácil de organizar, pero no ofrece la consistencia requerida por una base de datos SQL o Oracle que reside dentro de la instancia, y generalmente requiere una base de datos y una aplicación para recuperar la aplicación.